Il Wafer Scale Engine (WSE-3) di terza generazione a 5 nm alimenta i supercomputer AI più scalabili del settore, fino a 256 exaFLOP attraverso 2048 nodi.

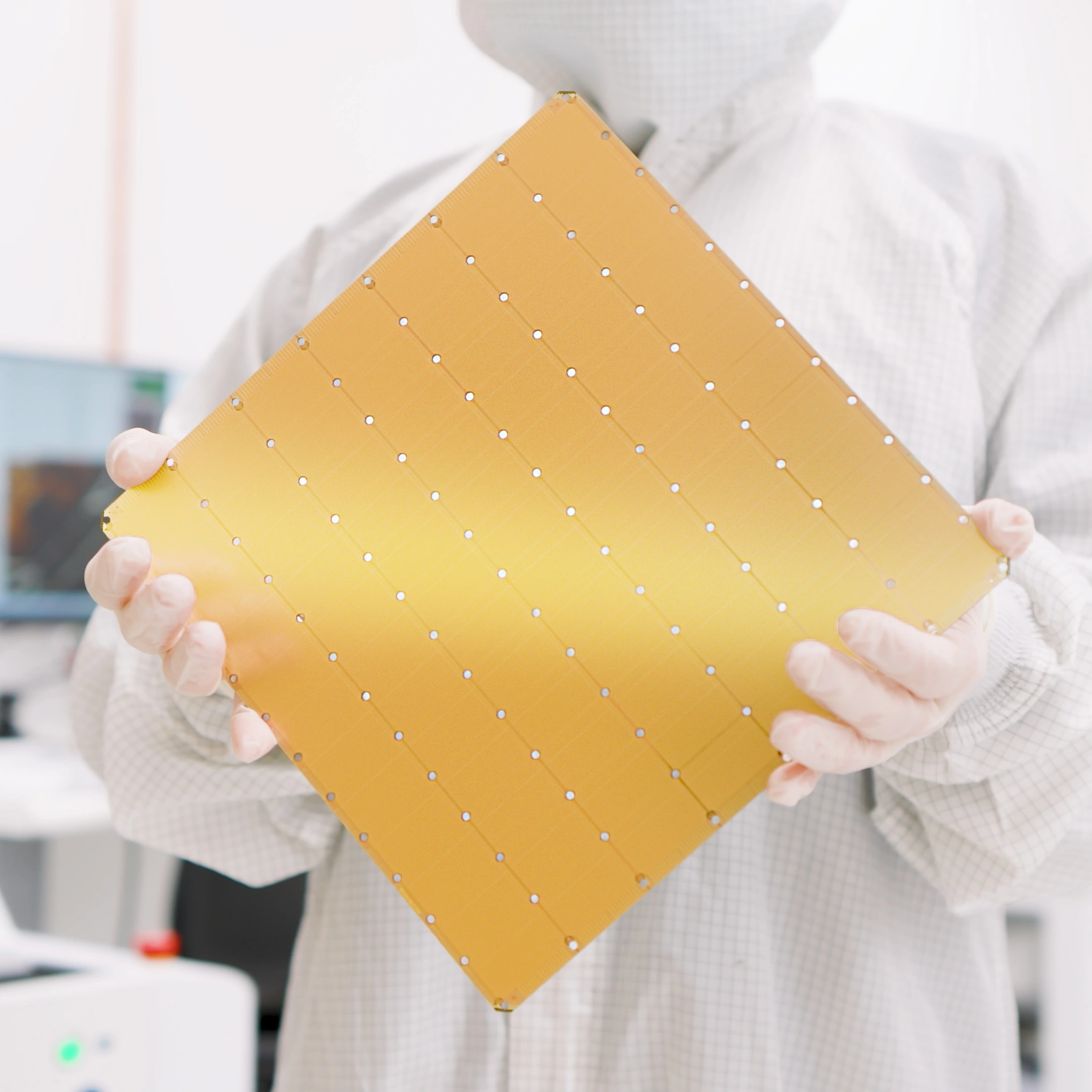

Cerebras Systems, pioniere nell’accelerazione dell’intelligenza artificiale generativa, ha raddoppiato il suo record mondiale di chip AI più veloce con l’introduzione del Wafer Scale Engine 3. Il WSE-3 offre il doppio delle prestazioni del precedente record, il Cerebras WSE-2, a parità di consumo energetico e di prezzo. Il WSE-3 offre prestazioni doppie rispetto al precedente detentore del record, il Cerebras WSE-2, a parità di potenza e di prezzo. Costruito appositamente per l’addestramento dei più grandi modelli di intelligenza artificiale del settore, il WSE-3, basato su 5 nm e con 4 trilioni di transistor, alimenta il supercomputer Cerebras CS-3 AI, offrendo 125 petaflops di prestazioni AI di picco grazie a 900.000 core di calcolo ottimizzati per l’AI.

Con un sistema di memoria enorme, fino a 1,2 petabyte, il CS-3 è stato progettato per addestrare modelli di frontiera di prossima generazione con dimensioni 10 volte superiori a GPT-4 e Gemini. 24 trilioni di modelli di parametri possono essere memorizzati in un unico spazio di memoria logica senza partizionamento o refactoring, semplificando notevolmente il flusso di lavoro di addestramento e accelerando la produttività degli sviluppatori. L’addestramento di un modello da un trilione di parametri sul CS-3 è semplice come l’addestramento di un modello da un miliardo di parametri sulle GPU.

Il cosiddetto chippone.